התאמת יתר

התאמת יתר (overfitting) היא בעיה יסודית בסטטיסטיקה ובלמידת מכונה שבה המודל מותאם יתר על המידה לאוסף מסוים של נתונים (למשל האוסף שהיה זמין לשם אימונו) ועל כן מצליח פחות בבצוע תחזיות. התאמת יתר מתרחשת כאשר המודל נקבע על ידי יותר פרמטרים מאשר הנתונים מצדיקים. עודף הפרמטרים מאפשר למודל ללמוד את הרעש הסטטיסטי כאילו הוא מייצג התנהגות אמיתית.

תת התאמה (Underfitting) לעומת זאת מתרחשת כאשר המודל הסטטיסטי פשוט מדי מכדי לייצג כראוי את המבנה הבסיסי של הנתונים, למשל בעקבות מיעוט בפרמטרים המגדירים את המודל. דוגמה לכך היא למשל ניסיון להשתמש במודל ליניארי לתיאור התנהגות לא ליניארית.

מקרים של התאמת יתר

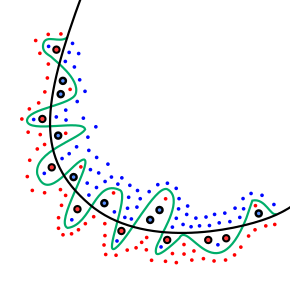

בתור דוגמה קיצונית להתאמת יתר, אם מספר הפרמטרים המשמשים להגדרת המודל זהה או גדול יותר מאשר מספר התצפיות, אזי המודל יוכל לחזות באופן מדויק את התצפיות פשוט על ידי זכירתן במלואן. ראו למשל את איור 2 להמחשה. מודל כזה בדרך כלל ייכשל קשות בעת ביצוע תחזיות. כדוגמה נוספת לבעייתיות של "מודל זוכר" שכזה - קחו בסיס נתונים של מכירות בחנות הכולל תאריכי רכישה, שם פריט וסכום. מודל עם מספיק פרמטרים יוכל פשוט לזכור את כל בסיס הנתונים וכך "לחזות" במדויק את סכומי הרכישה שבו על סמך התאריך. ברור אבל שמודל כזה לא יצליח לחזות סכומי רכישה של רכישות עתידיות.

התאמת יתר מתרחשת במקרים בהם חסרה תאוריה להנחיית האנליזה של הנתונים. במצב כזה יש צורך לבחון מספר רב של מודלים אפשריים ונדרשים יותר פרמטרים כדי להגדירם[1].

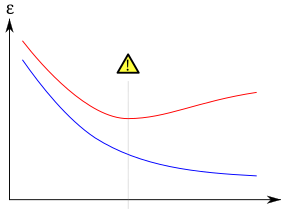

התאמת יתר מתרחשת לעיתים קרובות בבצוע רגרסיה ליניארית מרובה. במקרה הקיצוני אם מספר המשתנים המסבירים שווה למספר הדגימות אזי המודל יעבור במדויק בכל הנקודות. בדיקות הראו שמספיקות שתי דגימות לכל משתנה מסביר ברגרסיה ליניארית. עבור רגרסיה לוגיסטית או מודל קוקס (Cox proportional hazard models) קיימים מספר כללי אצבע - כמו כלל ה"אחד לעשר"[2]. בתהליך בחירת מודל הרגרסיה, ניתן להיעזר בשקלול הטיה-שונות (bias-variance tradeoff) בו השגיאה של המודל מפוצלת למרכיב הטיה (המרחק של המודל "הממוצע" מפונקציית המטרה) והשונות (הפיזור של המודלים הבאים בחשבון).

טיפול בהתאמת יתר

ישנן כמה שיטות מקובלות להפחתת הסכנה בהתאמת יתר. אלה כוללות למשל אימות צולב (cross-validation), רגולריזציה (regularization), עצירה מוקדמת (early stopping) וכן, גיזום (pruning). הבסיס לשיטות אלה הוא:

- מחיר מפורש למורכבות המודל (למשל ברגולריזציה) ובכך לתת לתהליך האופטימיזציה להעדיף פתרונות פשוטים. שיטה זו נקראת נקראת גם מבחן תערו של אוקאם, שעל פיו מודל מורכב הוא מראש סביר פחות ממודל פשוט. מורכבות המודל אינה נבחנת רק לפי מספר הפרמטרים אלא גם לפי מידת הביטוי של הפרמטרים.

- לבדוק באופן ישיר את יכולת המודל לבצע תחזיות על נתונים חדשים שלא שימשו בעת אימונו המקורי (למשל באימות צולב).

ראו גם

לקריאה נוספת

- שי שלו שוורץ ושי בן דוד, Understanding Machine Learning: From Theory to Algorithms, Cambridge University Press, 2014, פרקים 11 ו-13

קישורים חיצוניים

- קורס בלמידת מכונה מאוניברסיטת בן-גוריון שבנגב.

- קורס בלמידת מכונה מאוניברסיטת Caltech (אנגלית).

הערות שוליים

- ↑ Claeskens, G.; Hjort, N.L. (2008), Model Selection and Model Averaging, Cambridge University Press.

- ↑ Draper, Norman R.; Smith, Harry (1998). Applied Regression Analysis. John Wiley & Sons. ISBN 978-0471170822.

שגיאות פרמטריות בתבנית:מיון ויקיפדיה

שימוש בפרמטרים מיושנים [ דרגה ] התאמת יתר23364215