קוד תיקון שגיאות

קוד תיקון שגיאות הוא קוד בעל מספר תכונות שמאפשרות לשלוח באמצעותו אוסף של נתונים דרך ערוץ תקשורת רועש, ולנטרל במידה מסוימת את השפעת רעשי הרקע על המידע המתקבל. קודי התיקון פועלים על ידי הגדלת ההבדל בין המילים השונות בקוד, וכך הקטנת הסיכוי שרעש חיצוני יגרום לקליטת מילה השונה מהמילה שנשלחה. כאשר ההבדל בין מילות הקוד גדול במיוחד ניתן אפילו לתקן שגיאות, כל עוד מספר השגיאות קטן מספיק.

מבוא לא פורמלי

המוטיבציה המקורית לבניית קודים לתיקון שגיאות הייתה לצורך תקשורת מעל ערוץ רועש. בעת שליחת מידע על פני תווך פיזי כלשהו (למשל, כבל), עלולות לקרות שגיאות כתוצאה מתופעות פיזיקליות כלשהן (למשל, ביט כלשהו עלול להחליף את ערכו, או להמחק). על בעיה זו ניסה להתגבר קלוד שאנון בשני מאמרים משנת 1948 בהם הוא הציג את המונח של קוד לתיקון שגיאות (יחד עם הנחת היסודות של תורת האינפורמציה)[1][2]. שאנון הציע לקודד את ההודעה בהודעה ארוכה יותר, כך שאם נשלח את ההודעה הארוכה לאורך התווך במקום את ההודעה המקורית, נוכל לפענח ממנה את ההודעה המקורית, גם אם התווך ישבש את ההודעה ששודרה. אם כך, קוד במובן זה נתון על ידי פונקציית קידוד ופונקציית פענוח. שאנון חשב על התווך (במונחים של שאנון: ערוץ או Channel) כעל אובייקט אקראי, המשבש כל ביט בהסתברות ידועה מראש, וחיפש קודים עבורם ההסתברות שהתווך ישבש את ההודעה כל כך עד שפונקציית הפענוח תכשל היא נמוכה.

שנתיים מאוחר יותר, ב-1950, הציג ריצ'רד המינג גישה אחרת להגדרת קודים מתקני שגיאות[3]. המינג רצה שתמיד יהיה אפשר לפענח את מילת הקוד, בהינתן והתווך מוגבל בכמות הביטים שהוא משבש - כאילו היה התווך יריב זדוני בעל היכולת לשבש כמות כלשהי של הביטים המשודרים, במידה לבלבל את הצדדים המתקשרים כמה שאפשר. בגישה זו, במקום לנסות ולמזער את הסתברות השגיאה של המפענח, קוד במובן המינג מנסה להגדיל את המרחק בין כל שתי מילות קוד. בהכללה גסה, ניתן לחשוב על הגישה של המינג כגישת "המקרה הגרוע" (Worst Case) ועל הגישה של שאנון כגישת "המקרה הממוצע" (Average Case).

אינטואיציה עבור שני המובנים של קוד - המגיעה ממבט תאורטי יותר - היא שקוד לתיקון שגיאות מפזר את האינפורמציה של מילה על פני הרבה ביטים, כך שכל ביט נושא כמות קטנה יותר של מידע. באופן אינטואיטיבי, גם אם יימחקו כמה ביטים הנושאים אינפורמציה קטנה כל אחד מהם, עדיין המידע יהיה קריא, ואף אינפורמציה לא תאבד. אינטואיציה זו מסבירה אולי איך מצאו קודים לתיקון שגיאות הרבה שימושים ועניין רב גם מחוץ לתחום של תקשורת מחשבים, תופעה הנראית מפתיעה ממבט ראשון.

קודים במובן של המינג

הגדרה

במובן של המינג, אנחנו מתעלמים לחלוטין משלבי הקידוד והפענוח ופשוט חושבים על הקוד כעל אוסף של מילים. כך למשל התמונה של פונקציית הקידוד של קוד במובן שאנון היא קוד במובן של המינג. ובאופן פורמלי, אם הוא אלפבית (קבוצה סופית של סימנים), קוד הוא תת-קבוצה של אוסף המילים באורך , כלומר . למרות שגודל האפלבית אינו חייב להיות בינארי, עדיין המונח ביט משמש כשם לתו כללי ב. כדי למדוד את איכותו של הקוד, נעזרים בכמה פרמטרים של הקוד:

- גודל הבלוק (block size) הוא בכמה ביטים נעזרנו לקידוד. תחת הסימונים מעלה זהו .

- מימד הקוד (dimension) הוא כמה ביטים אפקטיביים של מידע קודדנו. כאינטואיציה לקראת ההגדרה, נחשוב למשל על קוד שגודלו הוא עבור איזשהו שלם, ניתן אז לזהות את הקוד עם אוסף כל המילים באורך (כקבוצות): , ולחשוב על הזיהוי הזה כפונקציית קידוד. לכן ניתן להגיד שהקוד מקודד ביטים באופן אפקטיבי. באופן מדויק יותר, יוגדר קצב הקוד כ- . פרמטר דומה הוא הקצב (rate): , המודד את היחס בין כמה ביטים אפקטיביים קודדנו, לעומת כמה ביטים נשלחו בפועל.

- מרחק הקוד (distance) מודד כמה רחוקות מילות הקוד זו מזו. זהו מרחק המינג (Hamming Distance) המקסימלי בין כל שתי מילות קוד. ובמדויק: כש הוא מרחק המינג בין ו, כלומר בכמה ביטים ו שונים זה מזה. באופן דומה לסימון עבור קצב, נהוג להגדיר גם מרחק יחסי: .

- גודל האפלבית הוא גודל האלפבית מעליו הקוד מוגדר. תחת הסימונים מעלה זהו .

נהוג לקרוא לקוד בעל גודל בלוק , קצב , מרחק , וגודל אלפבית , קוד .

דוגמאות בסיסיות

- קוד פשוט הוא חזרה על כל ביט מספר מסוים של פעמים. בעוד קוד זה יכול לזהות ולתקן שגיאות מול ערוץ במובן של שאנון, המבצע מחיקות אקראיות (שכן ההסברות שכל החזרות ימחקו הוא קטן בהינתן מספר גדול מספיק של חזרות), מול ערוץ במובן של האמינג הוא גרוע למדי, שכן כדי להרוס את הקידוד, מספיק ליריב זדוני למחוק את כל החזרות של ביט בודד. עבור 3 חזרות הקוד הוא: . זהו קוד .

- קוד פשוט נוסף הוא הוספת ספרת ביקורת. מקרה פרטי מעניין שלו הוא הוספת ביט זוגיות - בהינתן מילה בינארית באורך נוסיף לה ביט נוסף שיגרום לXOR של כל הביטים להיות 0. כלומר הקוד הוא . זהו קוד .

קודים ליניאריים

ערך מורחב – קוד ליניארי

ערך מורחב – קוד ליניארי

קודים מעניינים יותר יתקבלו אם נעניק לאלפבית מבנה כלשהו. בפרט, אם נחשוב על האלפבית כשדה סופי: , יקבל מבנה טבעי של מרחב וקטורי. קוד נקרא קוד ליניארי אם הוא תת מרחב ליניארי של . למרות שבמבט ראשוני נראה שהגדרה זו היא ספציפית למדי ומגבילה, רוב הקודים הטובים הידועים הם למעשה קודים ליניאריים. נשים לב לנקודות הבאות:

- המימד של קוד ליניארי (כקוד) שווה למימד שלו כמרחב וקטורי.

- מאחר שקוד ליניארי סגור תחת חיסור, ומאחר ומרחק המינג נשמר תחת חיסור, המרחק של קוד ליניארי שווה למשקל המינג (מספר הביטים שאינם אפס, או באופן שקול מרחק המינג ממילת האפס; מסומן ב-) המינימלי של מילת קוד שאינה מילת האפס:

אם כך, קוד ליניארי טוב הוא כזה שבו כל מילת קוד מזכירה את 0 מעט מאוד פעמים. דוגמה טבעית לאוסף כזה של אובייקטים הוא פולינומים. זהו הרעיון הבסיסי מאחורי קוד ריד-סולומון. אם נסמן את איברי השדה , ונבחר פרמטר , קוד ריד-סולומון יוגדר כך:

עובדה ידועה על פולינומים מעל שדות היא שכל פולינום ממעלה לכל היותר , יש לכל היותר אפסים, ועל כן זהו קוד .

באופן דומה מוגדרים קודים ליניאריים טובים נוספים, כדוגמת קוד האדאמארד (אנ') (הבנוי מכל הפונקציות הליניאריות) או קוד ריד-מולר (אנ') (הבנוי מכל הפולינומים במספר משתנים וממעלה חסומה).

קודים במובן של שאנון

הגדרה

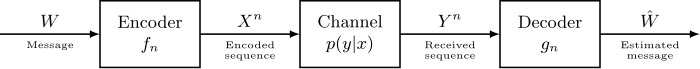

המודל עליו מסתכל שאנון בהגדרתו מורכב משלושה שלבים:

- השולח בוחר הודעה באקראי, מקודד אותה בעזרת פונקציית קידוד כלשהי, ושולח את ההודעה המקודדת מעל ערוץ.

- הערוץ משבש את ההודעה, בצורה אקראית כלשהי, המוגדרת על ידי הערוץ.

- המקבל קורא את ההודעה שיצאה מהערוץ, ומנסה לפענח אותה בעזרת פונקציית פענוח כלשהי.

אם כן, קוד מוגדר על ידי זוג פונקציות כש היא פונקציית קידוד הלוקחת הודעה באורך מעל אלפבית , ומחזירה הודעה באורך מעל אותו האלפבית, ו היא פונקציית פענוח הלוקחת הודעה באורך כלשהו (שכן הערוץ עלול לשנות את אורך ההודעה) מעל אלפבית (שכן הערוץ עלול להוציא סימנים הלקוחים מאלפבית אחר) ומחזירה את ההערכה שלה למה הייתה המחרוזת המקורית שנשלחה. באופן דומה לקודים במובן המינג, קצב הקוד (rate) נתון על ידי .

ערוץ מוגדר על ידי אוסף התפלגויות הנתמכות מעל , אחת לכל הודעה אפשרית ב. בהינתן הודעה ב, הערוץ פולט הודעה ב הנדגמת מההתפלגות של . בהינתן ערוץ, נרצה להגדיר את הקיבולת (Capacity) שלו, מדד של כמות המידע שהערוץ מסוגל להעביר מבלי לפגום בו. ישנן שתי דרכים להגדיר קיבולת:

- הגדרה כקצב המקסימלי: נאמר שקצב מסוים הוא בר-השגה (achievable), אם קיימת משפחה אינסופית של קודים, שכל קוד בה הוא עם קצב לפחות , ובנוסף ההסתברות שפונקציית הקידוד מבצעת בו שגיאה הולך וקטן עד ששואף ל-0. אם כך, קיבולת הערוץ תוגדר על ידי הקצב המקסימלי שהוא בר-השגה:

- הגדרה ככמות המידע שהערוץ משאיר: עבור פונקציית קידוד כלשהי , נסמן ב את המשתנה המקרי שמתקבל מקידוד הודעה אקראית וב את פלט הערוץ על . עבור שני משתנים אקראיים בדידים נסמן ב את האינפורמציה ההדדית שלהם, מדד לכמות המידע ששניהם חולקים. קיבולת הערוץ תוגדר כך:

ממשפט הקידוד מעל ערוץ, שתי ההגדרות שלעיל שקולות.

דוגמאות לערוצים

- הערוץ הסימטרי הבינארי (Binary Symmetric Channel), הנתון על ידי פרמטר ומסומן , מבצע פעולת החלפה עבור כל ביט. כלומר, עבור כל ביט בנפרד ובאופן בלתי תלוי, מחליף אותו (ממיר 0 ב-1, ו1 ב0) בהסתברות .

- ערוץ מחיקה בינארי (Binary Erasure Channel), הנתון על ידי פרמטר ומסומן , מוחק כל ביט בהסתברות , וכותב במקומו סימן כלשהו המסמן את המחיקה. לרוב סימן זה מסומן ב.

- ערוץ השמטה בינארי (Binary Deletion Channel), הנתון על ידי פרמטר , משמיט כל ביט בהסתברות . על כן, אורך הפלט של הערוץ אינו קבוע ובוודאי אינו בהכרח האורך של הקלט המקורי של הערוץ, מה שמקשה מאוד על האנליזה של ערוץ זה. הבעיה של לקבוע את הקיבולת של ערוץ זה היא בעיה פתוחה[4].

משפט הערוץ הרועש של שאנון

שאנון התעניין בחישוב הקיבולת של ערוץ, והצליח לחשב את הקיבולת של ערוץ סימטרי בינארי. משפט הערוץ הרועש של שאנון קובע כי לכל , הקיבולת של הערוץ הבינארי הוא , כש היא אנטרופיית שאנון של משתנה מקרי ברנולי עם הסתברות :

שימושים

בתקשורת מחשבים

קודים לתיקון שגיאות מאפשרים תקשורת אמינה מעל ערוץ רועש, על ידי קידוד ההודעה לפני שליחתה, ופענוח ההודעה (המורעשת) בהגעתה ליעד. לשימוש פרקטי, נרצה קודים לתיקון שגיאות בעלי קידוד ופענוח מהירים, ובעלי קצב גבוה. דוגמה בסיסית לקודים שכאלו הם קודי Longitual/Vertical Redundancy Check) LRC/VRC). בקודים אלו, נכתוב את המידע בצורת טבלה, כך שכבכל תא בטבלה ישב אחד מהביטים של ההודעה המקורית, ונוסיף סיבית זוגיות לכל שורה (בLRC) או עמודה (בVRC). בקודים אלו ניתן לזהות לכל היותר שגיאה אחת בכל שורה/עמודה (בLRC/VRC; בהתאמה), אך לא לתקן אותה. היתרון שלהם לעומת זאת הוא שהם יעילים ומאפשרים מימוש קל ומהיר בחומרה. ניתן לשלב בין שיטות אלה, בקוד VLRC, שם נשלח את ביט הבקרה לכל שורה ולכל עמודה. כעת ניתן לזהות עד 3 שגיאות, ואף לתקן שגיאה בודדת, באמצעות הצלבת השורה והעמודה שבהן התגלו שגיאות. שיטה זו שימושית ביותר בבדיקת קבוצה (Group Testing).

שיטות פופולריות נוספות לקידוד הן סיכום ביקורת (checksum) וCRC, בהן משורשרת לסוף ההודעה תוצאת פונקציה כלשהי של ההודעה. בעת הפענוח מחשבים את אותה הפונקציה על ההודעה שהגיעה, ומשווים זאת עם התוצאה הנתונה. הפונקציה נבחרת כך ששינויים רדנומיים בהודעה יגרמו לפלט הפונקציה להשתנות, וכך נוכל לזהות (אך לא בהכרח לתקן) שגיאות בעת העברת ההודעה בהסתברות טובה. יתרונם הגדול של שיטות אלו הוא פשטותם, ויעילותם הגבוהה.

שיטות מתקדמות יותר כוללות קודי קונבולוציה, וקודי LDPC.

במסדי נתונים

אם נאחסן מידע על החסן פיזי (דיסק קשיח, למשל), המידע עלול להמחק או לההרס עם הזמן (למשל דיסק שנשרט, או שרת שנופל). גם על בעיה זו ניתן להתגבר בעזרת קודים לתיקון שגיאות - במקום לאחסן את המידע עצמו, נאחסן את הקידוד של המידע עם קוד לתיקון שגיאות. כעת, גם אם חלק מהמידע יימחק, עדיין נוכל לשחזרו. בעיית האחסון במסד נתונים לא אמין לא סתם דומה לבעיית התקשורת מעל ערוץ רועש - היא ממש שקולה. ניתן לחשוב על אחסון במסד נתונים כעל "שליחת הודעה לעתיד", כלומר שליחת הודעה לרגע בו נרצה לקרוא את המידע ששמרנו.

בשימוש פרקטי, לרוב נעשה שימוש בקוד חזרות, בעיקר מאחר שהוא מתאים לשימוש במערכות אחסון מבוזרות. עם זאת, גם קודים אחרים שימושיים למדי ולמשל טכנולוגיית אחסון המידע RAID משתמשת בקוד ריד-סולומון.

במדעי המחשב התאורטיים

בעיה בסיסית בסיבוכיות תקשורת היא השוואה בין מחרוזות. בבעיה זאת, אליס מקבלת מחרוזת אחת, בוב מקבל מחרוזת שנייה, ואליס ובוב רוצים - בעזרת תקשורת מינימלית ביניהם - לדעת האם שתי המחרוזות שוות. פתרון טריוויאלי יהיה שאליס תשלח את המחרוזת שלה לבוב, ובוב ישווה ביניהם. אך פתרון זה דורש זה דורש כמות גדולה של תקשורת בין אליס ובוב (למעשה, פתרון זה הוא אופטימלי ללא שימוש ברנדומיות[5]). אך בהינתן ולאליס ולבוב יש גישה לאקראיות פומבית, כל אחד מהם יכול לקודד את המחרוזת שלו עם קוד לתיקון שגיאות (אותו הקוד עבור אליס ובוב) ולהתייחס לאקראיות הפומבית כאינדקס של ביט בקוד. אליס תשלח לבוב רק את הביט שבאותו האינדקס בקידוד שלה, ובוב ישווה בין הביט שבאותו האינדקס בקידוד שלו עצמו ובין הביט שהגיע מאליס. הוא יקבע שהמחרוזות שוות אם הביטים שהושוו אכן שווים. אם המחרוזות שהיו לאליס ובוב מלכתחילה היו שוות, גם הקידודים שלהם יהיו שווים ובוב תמיד יצדוק. אחרת, ההסתברות של בוב לענות נכונה היא לפחות המרחק (היחסי) של הקוד. אם אליס ובוב יבחרו קוד עם מרחק גדול, ההסתברות שלהם להצליח תהיה גדולה, בעוד רק ביט אחד נשלח.

קודים הם האובייקט הבסיסי בהרבה בניות של מערכות הוכחה הסתברותיות (Probabilistically Checkable Proofs)[6][7]. בתחום של קושי קירוב (השקול לבניית מערכות הוכחה הסתברותיות[8]), קודים משמשים לרוב כ"גדאדג'טים" ברדוקציות של קושי קירוב אופטימלי[9][10].

בדרנדומיזציה, קודים משמשים לבנייה של אובייקטיבים פסאודו-רנדומיים כמו מחלצי רדנומיות (Randomness Extractors) (אנ')[11] והתפלגויות עם הטיה קטנה (Small-Bias Distributions)(אנ')[12][13]. ידועים גם קשרים בין קודים לאובייקטים פסאודו-רנודמיים נוספים, כמו למשל גרפים מרחיבים[14].

ראו גם

לקריאה נוספת

- להוכחות של הטענות המוזכרות על קידוד ערוץ של שאנון, ראו פרק 5 בסיכומי ההרצאות האלו.

הערות שוליים

- ↑ C. E. Shannon, A Mathematical Theory of Communication, Bell System Technical Journal 27, 1948-07, עמ' 379–423 doi: 10.1002/j.1538-7305.1948.tb01338.x

- ↑ C. E. Shannon, A Mathematical Theory of Communication, Bell System Technical Journal 27, 1948-10, עמ' 623–656 doi: 10.1002/j.1538-7305.1948.tb00917.x

- ↑ R. W. Hamming, Error Detecting and Error Correcting Codes, Bell System Technical Journal 29, 1950-04, עמ' 147–160 doi: 10.1002/j.1538-7305.1950.tb00463.x

- ↑ Mitzenmacher, Michael, A survey of results for deletion channels and related synchronization channels, Probab. Surveys 6 (2009), עמ' 1-33 doi: 10.1214/08-PS141

- ↑ Anup Rao, Amir Yehudayoff, Communication Complexity: and Applications, Cambridge University Press, 2020-01-31, עמ' 22, משפט 1.14, מסת"ב 978-1-108-67164-4

- ↑ S. Arora, C. Lund, R. Motwani, M. Sudan, and M. Szegedy. Proof verification and intractability of approximation problems.Journal of the ACM, 45(3):501–555, 1998.

- ↑ S. Arora and S. Safra. Probabilistic checking of proofs: A new characterization ofNP.Journal of the ACM, 45(1):70–122, 1998

- ↑ U. Feige, S. Goldwasser, L. Lov ́asz, S. Safra, and M. Szegedy. Approximating clique is almost NP-complete.Journal of the ACM, 43(2):268–292, 1996

- ↑ Johan Håstad. 2001. Some optimal inapproximability results. J. ACM 48, 4 (July 2001), 798–859. DOI:https://doi.org/10.1145/502090.502098

- ↑ Subhash Khot, Guy Kindler, Elchanan Mossel, and Ryan O’Donnell. 2007. Optimal Inapproximability Results for MAX-CUT and Other 2-Variable CSPs? SIAM J. Comput. 37, 1 (April 2007), 319–357. DOI:https://doi.org/10.1137/S0097539705447372

- ↑ Luca Trevisan. Extractors and pseudorandom generators.Journal of the ACM, 48(4):860–879,2001.

- ↑ Naor, Joseph & Naor, Moni. (2001). Small-Bias Probability Spaces: Efficient Constructions and Applications. SIAM Journal on Computing. 22. 10.1145/100216.100244.

- ↑ A. Ben-Aroya and A. Ta-Shma, "Constructing Small-Bias Sets from Algebraic-Geometric Codes," 2009 50th Annual IEEE Symposium on Foundations of Computer Science, Atlanta, GA, 2009, pp. 191-197, doi: 10.1109/FOCS.2009.44.

- ↑ M. Sipser and D. A. Spielman. Expander codes.IEEE Trans. Inform. Theory,42(6,part 1):1710–1722, 1996. Codes and complexity. MR1465731 (98d:94031)

קוד תיקון שגיאות30629967