BERT (מודל שפה)

| גרסת בטא |

ב־March 11, 2020 |

|---|---|

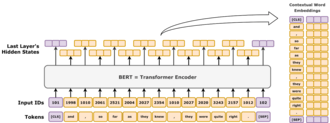

מודל BERT (Bidirectional Encoder Representations from Transformers) הוא מודל שפה שהוצג באוקטובר 2018 על ידי חוקרים ב-Google.[1] המודל לומד לייצג טקסט כרצף של וקטורים באמצעות למידה עצמית-מונחית (self-supervised learning). הוא מתבסס על ארכיטקטורת טרנספורמר הכוללת מקודד בלבד (encoder-only).

BERT נחשב לחדשני בזכות השיפור הדרמטי שהציג בהשוואה למודלים המתקדמים ביותר באותה תקופה, ונחשב גם לדוגמה מוקדמת למודל שפה גדול. נכון ל-2020, BERT משמש כבסיס נפוץ בניסויים בתחום עיבוד שפה טבעית (NLP).[2]

מודל BERT מאומן באמצעות שני תהליכי למידה: חיזוי מילים מוסתרות (masked token prediction) וחיזוי המשפט הבא (next sentence prediction). כתוצאה מתהליך האימון הזה, BERT לומד ייצוגים סמויים והקשריים של מילים בהתאם להקשר שבו הן מופיעות, בדומה למודלים כמו ELMo (אנ') ו-GPT-2 (אנ').[3]

למודל נמצאו שימושים רבים במשימות שונות בתחום עיבוד שפה טבעית, כגון פתרון בעיות של ייחוס התייחסות (אנ') ופענוח ריבוי משמעויות (אנ').[4] BERT מהווה שלב אבולוציוני לעומת ELMo (אנ'), והוביל למחקר שנקרא "ברטולוגיה" (BERTology), אשר מנסה לפרש ולהבין מה בדיוק BERT לומד במהלך תהליך האימון שלו.[2]

BERT הוטמע במקור בשפה האנגלית בשני גודלי מודל:

BERT BASE (110 מיליון פרמטרים) ו־BERT LARGE (340 מיליון פרמטרים). שני המודלים אומנו על Toronto BookCorpus[5] (800 מיליון מילים) ועל הוויקיפדיה האנגלית (2,500 מיליון מילים). משקלי המודל פורסמו לציבור ב־GitHub.[6] ב-11 במרץ 2020, שוחררו 24 גרסאות קטנות יותר של המודל, הקטן ביותר הוא BERT TINY, הכולל 4 מיליון פרמטרים בלבד.[6]

ארכיטקטורה

BERT מבוסס על ארכיטקטורת טרנספורמר "מקודד בלבד". ברמה גבוהה יותר, BERT מורכב מ-4 מודולים:

- Tokenizer: מודול זה ממיר פיסת טקסט באנגלית לרצף של מספרים שלמים ("טוקנים").

- Embedding (אנ') – הטמעה: מודול זה ממיר את רצף הטוקנים למערך של וקטורים בעלי ערך ממשי המייצגים את הטוקנים. המטרה היא להמיר את סוגי הטוקנים הבדידים למרחב אוקלידי בעל ממדים נמוכים יותר.

- Encoder – מקודד: מערך של בלוקי Transformer המשתמשים במנגנון תשומת לב עצמית (self-attention), אך ללא מיסוך סיבתי (causal masking).

- Task head – ראש משימה: מודול זה ממיר את וקטורי הייצוג הסופיים בחזרה לטוקנים המקודדים בצורת one-hot על ידי יצירת התפלגות הסתברות צפויה על סוגי הטוקנים. ניתן לראותו כמעין מפענח פשוט (decoder), שמפענח את הייצוג הסמוי לסוגי טוקנים.

ראש המשימות הכרחי לשלב האימון המקדים, אך לרוב הוא מיותר עבור משימות המכונות "משימות המשך", כגון מענה לשאלות או סיווג רגשות. במקום זאת, מסירים את ראש המשימה ומחליפים אותו במודול חדש המותאם למשימה הספציפית, ומבצעים כוונון עדין (fine-tuning) למודול החדש. ייצוג הווקטור הסמוי של המודל מוזן ישירות למודול החדש הזה, ומאפשר למידת העברה (אנ') יעילה על בסיס דוגמאות מועטות.[7]

הטמעה

סעיף זה מתאר את ההטמעה בשימוש על ידי BERT BASE. אופן הטמעת הדגם השני, BERT LARGE, דומה, רק גדול יותר.

הטוקנייזר של BERT הוא WordPiece, שהיא אסטרטגיה לפירוק מילים לתת-מילים. גודל אוצר המילים של המודל הוא 30,000, וכל טוקן שלא מופיע באוצר המילים מוחלף ב - [UNK] ("לא ידוע").

השכבה הראשונה היא שכבת ההטמעה, המכילה שלושה מרכיבים: הטמעת סוגי טוקנים, הטמעת מיקומים והטמעת סוגי מקטעים.

- סוג הטוקן: סוג הטוקן הוא שכבת הטמעה סטנדרטית, הממירה וקטור one-hot לווקטור דחוס המבוסס על סוג הטוקן.

- מיקום: הטמעות המיקום מבוססות על המיקום של הטוקן ברצף. BERT משתמש במיקומים מוחלטים, שבהם כל מיקום ברצף ממופה לווקטור בעל ערכים ממשיים. כל מימד בווקטור מורכב מפונקציה סינוסואידית (אנ') שלוקחת את המיקום ברצף כקלט.

- סוג המקטע: באמצעות אוצר מילים של 0 או 1 בלבד, שכבת הטמעה זו מייצרת וקטור צפוף על סמך האם הטוקן שייך למקטע הטקסט הראשון או השני באותו קלט. במילים אחרות, טוקנים מסוג 1 הם כל הטוקנים המופיעים אחרי הטוקן המיוחד

[SEP].

שלושת הווקטורים המוטבעים מתווספים יחד המייצגים את ייצוג ה הראשוני כפונקציה של שלוש פיסות המידע הללו. לאחר ההטמעה, ייצוג הווקטור מנורמל באמצעות פעולת LayerNorm, תוך פלט וקטור של 768 ממדים עבור כל קלט. לאחר מכן, וקטורי הייצוג מועברים קדימה דרך 12 בלוקים מקודד שנאי, ומפוענחים חזרה למרחב אוצר מילים של 30,000 ממדים באמצעות שכבת טרנספורמציה אפינית בסיסית.

משפחת ארכיטקטורה

למחסנית המקודד של BERT יש 2 פרמטרים חופשיים: , מספר השכבות, ו - , הגודל הנסתר. תמיד יש ראשי תשומת לב עצמית, וגודל ההזנה/המסנן הוא תמיד . על ידי שינוי של שני המספרים הללו, ניתן לקבל משפחת מודלים שלמה של BERT.[8]

עבור BERT

- גודל ההזנה קדימה וגודל המסנן הם מילים נרדפות. שניהם מציינים את מספר הממדים בשכבה האמצעית של רשת ההזנה קדימה.

- הגודל הנסתר וגודל ההטמעה גם הם מושגים נרדפים. שניהם מציינים את מספר המספרים הממשיים המשמשים לייצוג טוקן.

הסימון עבור מחסנית המקודד נכתב כ-L/H. לדוגמה, BERT BASE כתוב כ-12L/768H, BERT LARGE כ-24L/1024H, ו-BERT TINY כ-2L/128H.

אימון המודל

אימון מקדים (Pre-training)

BERT אומן מראש בו-זמנית על שתי משימות:[9]

חיזוי מילים מוסתרות (Masked language modeling)

במודל של חיזוי בשיטת טוקנים מוסתרים, 15% מהטוקנים ייבחרו באופן אקראי למשימת חיזוי-מוסתר, ומטרת האימון היא לחזות את הטוקן המכוסה בהתחשב בהקשר שלו. בפירוט, הטוקן הנבחר:

- מוחלף בטוקן-מסיכה

[MASK]בסבירות של 80%, - מוחלף בטוקן מילה אקראית בסבירות של 10%,

- לא מוחלף בסבירות של 10%.

הסיבה שלא כל הטוקנים הנבחרים מוסתרים היא כדי להימנע מבעיית שינוי במערך הנתונים (Dataset Shift). בעיה זו מתעוררת כאשר התפלגות הקלטים הנראים במהלך האימון שונה באופן משמעותי מההתפלגות בה נתקל המודל במהלך השימוש. מודל BERT מאומן עשוי להיות מיושם על ייצוג מילים (כמו Word2Vec), שבו הוא יופעל על משפטים שלא מכילים טוקני [MASK]. בהמשך נמצא שתוצאות אימון מגוונות יותר הן בדרך כלל טובות יותר.[10]

כדוגמה להמחשה, נחשב את המשפט "הכלב שלי חמוד". המשפט יחולק תחילה לטוקנים כמו "הכלב 1 שלי 2 חמוד 3 ". לאחר מכן ייבחר טוקן אקראי במשפט. נניח שיהא זה השלישי, " 3 חמוד". בשלב הבא, יהיו שלוש אפשרויות:

- בסבירות של 80%, הטוקן שנבחר מוסתר, וכתוצאה מכך "הכלב 1 שלי 2

[MASK]3 "; - בסבירות של 10%, הטוקן שנבחר מוחלף בטוקן אקראי שנדגם באופן אחיד, כגון "שמח", וכתוצאה מכך "כלב 1 שלי 2 שמח 3 ";

- בסבירות של 10%, שום דבר לא נעשה, וכתוצאה מכך "כלב 1 שלי 2 חמוד 3 ".

לאחר עיבוד טקסט הקלט, וקטור הפלט הרביעי של המודל מועבר לשכבת המפענח שלו, שמפיקה התפלגות הסתברויות על פני מרחב אוצר המילים בגודל 30,000.

חיזוי המשפט הבא (Next sentence prediction)

בהינתן שני קטעי טקסט, המודל חוזה אם שני המקטעים הופיעו ברצף בקורפוס האימון, ומפיק את אחת התויות [IsNext] או [NotNext]. הקטע הראשון מתחיל עם התו המיוחד [CLS] (מסמן "סיווג"). שני הקטעים מופרדים על ידי תו מיוחד [SEP] (מסמן "הפרדה"). לאחר עיבוד שני המקטעים, וקטור הפלט הראשון (הווקטור המייצג את [CLS]) מועבר לרשת עצבית נפרדת לצורך הסיווג הבינארי ל-[IsNext] ו-[NotNext].

- לדוגמה, בהינתן "

[CLS]הכלב שלי חמוד[SEP]הוא אוהב לשחק", המודל צריך להוציא[IsNext]. - בהתחשב ב"

[CLS]הכלב שלי חמוד[SEP]איך מגנטים עובדים" המודל צריך להוציא[NotNext].

כוונון המודל (Fine-tuning)

BERT נועד להיות מודל כללי מאומן מראש עבור יישומים שונים בעיבוד שפה טבעית. כלומר, לאחר האימון המקדים, ניתן לכוונן את BERT עם פחות משאבים על מערכי נתונים קטנים יותר, כדי לייעל את הביצועים שלו במשימות ספציפיות כגון הסקת מסקנות משפה טבעית, סיווג טקסט, וכן במשימות יצירת שפה מבוססות רצף כמו שאלות ותשובות ושיחה.[11]

המאמר המקורי של BERT פרסם תוצאות המדגימות איך כמות קטנה של כוונון עדין (עבור BERT LARGE, שעה אחת על 1 Cloud TPU) אפשרה לו להשיג ביצועים מתקדמים יותר במספר משימות של הבנת שפה טבעית:[12]

- ערכת משימות GLUE (הערכת הבנת שפה כללית) (המורכבת מ-9 משימות);

- SQuAD (Stanford Question Answering Dataset) v1.1 ו-v2.0;

- SWAG (מצבים עם דורות יריבים).

במאמר המקורי, כל הפרמטרים של BERT מכוונים עדין, ומומלץ, עבור יישומים במורד הזרם שהם סיווגי טקסט, הפלט ב הקלט [CLS] יוזן לשכבה ליניארית-softmax כדי לייצר את פלטי התווית.[13]

עלות

BERT הוכשר על BookCorpus (800 מיליון מילים) וגרסה מסוננת של ויקיפדיה האנגלית (2,500 מיליון מילים) ללא רשימות, טבלאות וכותרות.

אימון BERT BASE על 4 TPU בענן (16 שבבי TPU בסך הכל) ארך 4 ימים, בעלות משוערת של 500 דולר.[6] אימון BERT LARGE על 16 TPU בענן (סה"כ 64 שבבי TPU) ארך 4 ימים.

פשר

מודלים של שפה כמו ELMo, GPT-2 ו-BERT, הולידו את המחקר של "BERTology", המנסה לפרש את מה שנלמד על ידי המודלים הללו. הביצועים שלהם במשימות הבנת השפה הטבעית הללו עדיין אינם מובנים היטב.[2][14][13] מספר פרסומי מחקר בשנים 2018 ו-2019 התמקדו בחקירת הקשר מאחורי הפלט של BERT כתוצאה מרצפי קלט שנבחרו בקפידה,[15][16] ניתוח של ייצוגים וקטורים פנימיים באמצעות בדיקה של מסווגים,[17][18] והקשרים המיוצגים על ידי משקלי תשומת לב.[14][13]

ניתן לייחס גם את הביצועים הגבוהים של מודל BERT[דרוש מקור] לעובדה שהוא מאומן באופן דו-כיווני. המשמעות היא ש-BERT, המבוססת על ארכיטקטורת מודל ה-Transformer, מיישמת את מנגנון הקשב העצמי שלו כדי ללמוד מידע מטקסט מצד שמאל ומימין במהלך האימון, וכתוצאה מכך זוכה להבנה עמוקה של ההקשר. לדוגמה, למילה בסדר יכולות להיות שתי משמעויות שונות בהתאם להקשר (אני מרגיש בסדר היום, יש לה שיער בלונדיני דק). BERT מחשיב את המילים המקיפות את מילת המטרה בסדר מצד שמאל וימין.

עם זאת, זה כרוך במחיר: עקב ארכיטקטורת מקודד בלבד חסרה מפענח, BERT לא יכול לקבל הנחיה ואינו יכול ליצור טקסט, בעוד מודלים דו-כיווניים באופן כללי אינם פועלים ביעילות ללא הצד הימני, ולכן קשה לבצע הנחיה. כדוגמה להמחשה, אם רוצים להשתמש ב-BERT כדי להמשיך בקטע משפט "היום, הלכתי אליו", אז בתמימות אפשר להסוות את כל הים כ"היום, הלכתי אל [MASK] [MASK] [MASK] ... [MASK]." כאשר המספר של [MASK] הוא אורך המשפט שאליו רוצים להאריך. עם זאת, זה מהווה שינוי במערך נתונים, שכן במהלך האימון, BERT מעולם לא ראה משפטים עם כל כך הרבה ים מוסווים. כתוצאה מכך, הביצועים שלו יורדים. טכניקות מתוחכמות יותר מאפשרות יצירת טקסט, אך בעלות חישובית גבוהה.[19]

היסטוריה

BERT פורסם במקור על ידי חוקרי גוגל ג'ייקוב דוולין, מינג-וויי צ'אנג, קנטון לי וקריסטינה טוטנובה. מקורו של העיצוב מייצוג הקשרי טרום-אימון, כולל למידת רצף בפיקוח למחצה, אימון מקדים גנרטיבי, ELMo, ו-ULMFit. שלא כמו דגמים קודמים, BERT הוא ייצוג דו-כיווני עמוק, ללא פיקוח, שהוכשר מראש באמצעות קורפוס טקסט רגיל בלבד. מודלים נטולי הקשר כגון word2vec או GloVe מייצרים ייצוג הטמעת מילה אחת עבור כל מילה באוצר המילים, בעוד BERT לוקח בחשבון את ההקשר לכל הופעה של מילה נתונה. לדוגמה, בעוד שלווקטור עבור "ריצה" יהיה אותו ייצוג וקטור של word2vec עבור שני המופעים שלו במשפטים "הוא מנהל חברה" ו"הוא רץ מרתון", BERT יספק הטבעה בהקשר שתהיה שונה לפי המשפט.[3]

ב-25 באוקטובר 2019, גוגל הודיעה שהיא החלה ליישם מודלים של BERT עבור שאילתות חיפוש שפה האנגלית בארצות הברית.[20] ב-9 בדצמבר 2019, דווח כי BERT אומצה על ידי חיפוש Google עבור למעלה מ-70 שפות.[21][22] באוקטובר 2020, כמעט כל שאילתה מבוססת אנגלית עובדה על ידי מודל BERT.[23]

גרסאות

דגמי BERT היו משפיעים והיוו השראה לגרסאות רבות.

RobERTa (2019)[24] היה שיפור הנדסי. הוא משמר את הארכיטקטורה של BERT (קצת יותר גדולה, ב-355 מיליון פרמטרים), אך משפר את ההכשרה שלו, משנה את הפרמטרים ההיפר-פרמטרים, מסיר את משימת החיזוי של המשפט הבא ומשתמש בגדלים גדולים בהרבה של מיני-אצווה.

DistilBERT (2019) מזקקת את BERT BASE למודל עם רק 60% מהפרמטרים שלו (66 מיליון), תוך שמירה על 95% מציוני המדדים שלו.[25][26] באופן דומה, TinyBERT (2019)[27] הוא דגם מזוקק עם רק 28% מהפרמטרים שלו.

ALBERT (2019)[28] השתמש בפרמטר משותף על פני שכבות, והתנסה בשינוי עצמאי של הגודל הנסתר וגודל הפלט של שכבת הטמעת המילים כשני היפרפרמטרים. הם גם החליפו את משימת חיזוי המשפט הבאה במשימת חיזוי סדר המשפט (SOP), שבה המודל חייב להבחין בין הסדר הנכון של שני קטעי טקסט עוקבים מהסדר ההפוך שלהם.

ELECTRA (2020)[29] יישמה את הרעיון של רשתות יריבות יצירתיות במשימת ה-MLM. במקום להסתיר ים, מודל שפה קטן מייצר תחליפים סבירים אקראיים, ורשת גדולה יותר מזהה את הים שהוחלפו. הדגם הקטן שואף להטעות את הדגם הגדול.

דברטה

DeBERTa (2020)[30] הוא וריאנט אדריכלי משמעותי, עם תשומת לב מפורקת. הרעיון המרכזי שלו הוא להתייחס לקידוד המיקום וה בנפרד לאורך מנגנון הקשב. במקום לשלב את הקידוד המיקום () וקידוד () לתוך וקטור קלט יחיד (), DeBERTa שומר אותם נפרדים כטופל: ( ). לאחר מכן, בכל שכבת קשב עצמית, DeBERTa מחשב שלוש מטריצות קשב נפרדות, במקום את מטריצת הקשב הבודדת המשמשת ב-BERT: [note 1]

| סוג תשומת לב | סוג שאילתה | סוג מפתח | דוּגמָה |

|---|---|---|---|

| תוכן לתוכן | אסימון | אסימון | "אירופי"; "איחוד", "יבשת" |

| תוכן למיקום | אסימון | מצב | [תואר]; +1, +2, +3 |

| מיקום לתוכן | מצב | אסימון | - 1; "לא", "מאוד" |

שלושת מטריצות הקשב מתווספות יחדיו מבחינה אלמנטית, ואז עוברות דרך שכבת softmax ומוכפלים במטריצת הקרנה.

קידוד מיקום מוחלט כלול בשכבת הקשב העצמי הסופית כקלט נוסף.

קישורים חיצוניים

אתר האינטרנט הרשמי של BERT

אתר האינטרנט הרשמי של BERT

הערות שוליים

- ↑ "Open Sourcing BERT: State-of-the-Art Pre-training for Natural Language Processing". Google AI Blog (באנגלית). 2 בנובמבר 2018. נבדק ב-2019-11-27.

{{cite web}}: (עזרה) - ^ 2.0 2.1 2.2 Rogers, Anna; Kovaleva, Olga; Rumshisky, Anna (2020). "A Primer in BERTology: What We Know About How BERT Works". Transactions of the Association for Computational Linguistics. 8: 842–866. arXiv:2002.12327. doi:10.1162/tacl_a_00349.

- ^ 3.0 3.1 Ethayarajh, Kawin (2019-09-01), How Contextual are Contextualized Word Representations? Comparing the Geometry of BERT, ELMo, and GPT-2 Embeddings, arXiv:1909.00512

- ↑ Anderson, Dawn (2019-11-05). "A deep dive into BERT: How BERT launched a rocket into natural language understanding". Search Engine Land (באנגלית). נבדק ב-2024-08-06.

- ↑ Zhu, Aligning Books and Movies: Towards Story-Like Visual Explanations by Watching Movies and Reading Books

- ^ 6.0 6.1 6.2 "BERT". GitHub. נבדק ב-28 במרץ 2023.

{{cite web}}: (עזרה) - ↑ Zhang, Tianyi; Wu, Felix; Katiyar, Arzoo; Weinberger, Kilian Q.; Artzi, Yoav (2021-03-11), Revisiting Few-sample BERT Fine-tuning, arXiv:2006.05987

- ↑ Turc, Iulia; Chang, Ming-Wei; Lee, Kenton; Toutanova, Kristina (2019-09-25), Well-Read Students Learn Better: On the Importance of Pre-training Compact Models, arXiv:1908.08962

- ↑ "Summary of the models — transformers 3.4.0 documentation". huggingface.co. נבדק ב-2023-02-16.

- ↑ Tay, Yi; Dehghani, Mostafa; Tran, Vinh Q.; Garcia, Xavier; Wei, Jason; Wang, Xuezhi; Chung, Hyung Won; Shakeri, Siamak; Bahri, Dara (2023-02-28), UL2: Unifying Language Learning Paradigms, arXiv:2205.05131

- ↑ Zhang, Aston; Lipton, Zachary; Li, Mu; Smola, Alexander J. (2024). "11.9. Large-Scale Pretraining with Transformers". Dive into deep learning. Cambridge New York Port Melbourne New Delhi Singapore: Cambridge University Press. ISBN 978-1-009-38943-3.

- ↑ Devlin, Jacob; Chang, Ming-Wei; Lee, Kenton; Toutanova, Kristina (11 באוקטובר 2018). "BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding". arXiv:1810.04805v2 [cs.CL].

{{cite arxiv}}: (עזרה) - ^ 13.0 13.1 13.2 Clark, Kevin; Khandelwal, Urvashi; Levy, Omer; Manning, Christopher D. (2019). "What Does BERT Look at? An Analysis of BERT's Attention". Proceedings of the 2019 ACL Workshop BlackboxNLP: Analyzing and Interpreting Neural Networks for NLP. Stroudsburg, PA, USA: Association for Computational Linguistics: 276–286. arXiv:1906.04341. doi:10.18653/v1/w19-4828.

- ^ 14.0 14.1 Kovaleva, Olga; Romanov, Alexey; Rogers, Anna; Rumshisky, Anna (בנובמבר 2019). "Revealing the Dark Secrets of BERT". Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing (EMNLP-IJCNLP) (באנגלית אמריקאית). pp. 4364–4373. doi:10.18653/v1/D19-1445.

{{cite book}}: (עזרה) - ↑ Khandelwal, Urvashi; He, He; Qi, Peng; Jurafsky, Dan (2018). "Sharp Nearby, Fuzzy Far Away: How Neural Language Models Use Context". Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). Stroudsburg, PA, USA: Association for Computational Linguistics: 284–294. arXiv:1805.04623. doi:10.18653/v1/p18-1027.

- ↑ Gulordava, Kristina; Bojanowski, Piotr; Grave, Edouard; Linzen, Tal; Baroni, Marco (2018). "Colorless Green Recurrent Networks Dream Hierarchically". Proceedings of the 2018 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1 (Long Papers). Stroudsburg, PA, USA: Association for Computational Linguistics. pp. 1195–1205. doi:10.18653/v1/n18-1108.

- ↑ Giulianelli, Mario; Harding, Jack; Mohnert, Florian; Hupkes, Dieuwke; Zuidema, Willem (2018). "Under the Hood: Using Diagnostic Classifiers to Investigate and Improve how Language Models Track Agreement Information". Proceedings of the 2018 EMNLP Workshop BlackboxNLP: Analyzing and Interpreting Neural Networks for NLP. Stroudsburg, PA, USA: Association for Computational Linguistics: 240–248. arXiv:1808.08079. doi:10.18653/v1/w18-5426.

- ↑ Zhang, Kelly; Bowman, Samuel (2018). "Language Modeling Teaches You More than Translation Does: Lessons Learned Through Auxiliary Syntactic Task Analysis". Proceedings of the 2018 EMNLP Workshop BlackboxNLP: Analyzing and Interpreting Neural Networks for NLP. Stroudsburg, PA, USA: Association for Computational Linguistics: 359–361. doi:10.18653/v1/w18-5448.

- ↑ Patel. "Bidirectional Language Models Are Also Few-shot Learners". arXiv:2209.14500.

- ↑ Nayak, Pandu (25 באוקטובר 2019). "Understanding searches better than ever before". Google Blog. נבדק ב-10 בדצמבר 2019.

{{cite web}}: (עזרה) - ↑ "Understanding searches better than ever before". Google (באנגלית אמריקאית). 2019-10-25. נבדק ב-2024-08-06.

- ↑ Montti, Roger (10 בדצמבר 2019). "Google's BERT Rolls Out Worldwide". Search Engine Journal. נבדק ב-10 בדצמבר 2019.

{{cite web}}: (עזרה) - ↑ "Google: BERT now used on almost every English query". Search Engine Land. 2020-10-15. נבדק ב-2020-11-24.

- ↑ Liu. "RoBERTa: A Robustly Optimized BERT Pretraining Approach". arXiv:1907.11692.

- ↑ Sanh, Victor; Debut, Lysandre; Chaumond, Julien; Wolf, Thomas (2020-02-29), DistilBERT, a distilled version of BERT: smaller, faster, cheaper and lighter, arXiv:1910.01108

- ↑ "DistilBERT". huggingface.co. נבדק ב-2024-08-05.

- ↑ Jiao, Xiaoqi; Yin, Yichun; Shang, Lifeng; Jiang, Xin; Chen, Xiao; Li, Linlin; Wang, Fang; Liu, Qun (2020-10-15), TinyBERT: Distilling BERT for Natural Language Understanding, arXiv:1909.10351

- ↑ Lan, Zhenzhong; Chen, Mingda; Goodman, Sebastian; Gimpel, Kevin; Sharma, Piyush; Soricut, Radu (2020-02-08), ALBERT: A Lite BERT for Self-supervised Learning of Language Representations, arXiv:1909.11942

- ↑ Clark, Kevin; Luong, Minh-Thang; Le, Quoc V.; Manning, Christopher D. (2020-03-23), ELECTRA: Pre-training Text Encoders as Discriminators Rather Than Generators, arXiv:2003.10555

- ↑ He, Pengcheng; Liu, Xiaodong; Gao, Jianfeng; Chen, Weizhu (2021-10-06), DeBERTa: Decoding-enhanced BERT with Disentangled Attention, arXiv:2006.03654

BERT (מודל שפה)41705100Q61726893